Lichtfelder ermöglichen das Errechnen von Bildern, die mit konventioneller Optik realistisch nicht aufgenommen werden können. Das Beispiel zeigt, wie eine Lichtfeldaufnahme aus einer Kamera mit einer zirka einen Meter großen Blende simuliert wird. Die geringe Tiefenschärfe, die durch den enormen Blendendurchmesser entsteht, lässt Objekte im Vordergrund (beim Fokussieren auf Hintergrundobjekte) fast ganz verschwinden. Bildcredit: Institut für Computergrafik der Johannes Kepler Universität Linz

Lichtfelder ermöglichen das Errechnen von Bildern, die mit konventioneller Optik realistisch nicht aufgenommen werden können. Das Beispiel zeigt, wie eine Lichtfeldaufnahme aus einer Kamera mit einer zirka einen Meter großen Blende simuliert wird. Die geringe Tiefenschärfe, die durch den enormen Blendendurchmesser entsteht, lässt Objekte im Vordergrund (beim Fokussieren auf Hintergrundobjekte) fast ganz verschwinden. Bildcredit: Institut für Computergrafik der Johannes Kepler Universität Linz

Herr Bimber, Sie sehen in Lichtfeldern die Zukunft digitaler Bilder. Was können wir uns darunter vorstellen?

Bisher wird unsere dreidimensionale Welt in vielen Fällen zweidimensional abgebildet. Das ist zum Beispiel bei Display-Systemen wie dem Fernsehen oder bei Imaging-Systemen wie der Fotografie oder der digitalen Bildverarbeitung der Fall. Wie Sie sich sicher vorstellen können, sind zweidimensionale Bilder keine optimale Repräsentation unserer Welt – auch nicht nach dem Schritt von den analogen hin zu den digitalen Technologien, die wir heute haben und fast ausschließlich verwenden. Hier seien nur beispielsweise die Digitalfotografie oder digitale Bildschirme erwähnt.

Die Frage ist nun, was eine bessere Repräsentationsform ist. Nun denkt man sicherlich zunächst an eine dreidimensionale Repräsentationsform, wie sie von Tiefenkameras wie „Microsoft Kinect“ aufgenommen wird, oder von stereoskopischen Displays wie 3-D-Fernsehern wiedergegeben wird. Leider ist das auch keine vollständige Repräsentation. Sie beschränkt sich nämlich auf rein diffuse Oberflächen, die Licht unabhängig der Reflektionsrichtung gleich reflektieren. Alltägliche Objekte transportieren Licht aber in komplizierterer Form. Denken Sie zum Beispiel an transparente Objekte oder spiegelnde Oberflächen. Hier funktionieren Tiefenkameras nicht mehr.

Wenn man also eine reale Szene in geeigneter und vollständiger Form repräsentieren möchte, dann müsste man den gesamten Lichttransport der Szene betrachten. Man müsste also wissen, welche Helligkeit und Farbe das Licht hat, das von jedem 3-D-Punkt der Szene in eine beliebige Richtung abgestrahlt wird. Richtungen kann man sphärisch mit zwei Dimensionen darstellen. Diese Kombination der 3-D- und 2-D-Funktionen nennt man in der Physik die „Plenoptische Funktion“. Sie beschreibt eine 3-D-Szene vollständig in fünf Dimensionen, da drei nicht ausreichend wären. Ziel ist es also, digitale Bilder, welche lediglich 2-D-Projektionen der plenoptischen 5-D-Funktionen sind, durch die plenoptische Funktion zu ersetzen. Hätte man ein Display, das anstelle von 2-D-Bildern die plenoptische Funktion der Szene in 5-D wiedergibt, hätte man ein perfektes dreidimensionales Display. Stereoskopische Displays sind aber weit davon entfernt. Eine Kamera, die die 5-D-plenoptische Funktion aufnimmt, wäre ein perfektes Imaging-System. Leider ist es nicht möglich, die plenoptische Funktion vollständig mit Kameras abzutasten oder mit Displays wiederzugeben.

Lichtfelder sind 4-D-Auszüge der 5-D-plenoptischen Funktion und dabei ihre bestmögliche Annäherung. Sie sind um einiges mächtiger, als 2-D-Bilder oder 3-D-Daten eines Tiefensensors.

Denkt man also an die mögliche Weiterentwicklung von zweidimensionalen Bildern, bildgebenden und Display-Systemen, dann wäre die logische Konsequenz die Lichtfeldtechnologie. Sie ist fast so vollständig wie die Holografie und bei weitem aber nicht so komplex.

Lichtfelder haben also das Potential all das radikal zu verändern, was wir heute mit digitalen Bildern in Verbindung bringen – und das ist eine ganze Menge: Nicht nur die Fotografie, sondern bildgebende Systeme allgemein, über die digitale Bildverarbeitung, Visualisierung, Computergrafik, bis hin zu Displaysystemen und Fernsehtechnologie. All das könnte in Zukunft anstelle von digitalen Bildern, auf Lichtfeldern basieren. Die Vorteile sind immens: Mehr Möglichkeiten in der Fotografie, perfektes 3-D-TV ohne Brille und für beliebig viele Betrachter, enorme Verbesserungen in digitalen Bildverarbeitung, und vieles mehr.

Wie zeichnet eine Lichtfeldkamera diese zahlreichen Zusatzinformationen auf?

Es gibt eine ganze Reihe von Möglichkeiten, Lichtfelder aufzunehmen. Angefangen von kodierten Blenden in Kameras – das sind Blenden, die nicht einfach eine Öffnung in entsprechendem Durchmesser haben, sondern ein binäres oder Graustufen-Muster – bis hin zu sogenannten Kamera-Arrays, große Matrizen aus hunderten kleiner Einzelkameras. Die momentan gängigste Variante ist die Verwendung einer Mikrolinsen-Matrix vor dem eigentlichen Bildsensor. Die Mikrolinsen bilden das Licht, das durch das Objektiv in die Kamera fällt in einer vierdimensionalen Kodierung auf dem Bildsensor ab. Bei einer normalen Kamera, nimmt man lediglich 2-D-Ortsinformationen auf, das heißt ein Pixel entspricht einem Ort. Eine Lichtfeldkamera nimmt jedoch 2-D-Ortsinformationen und 2-D-Richtungsinformationen auf. Man zeichnet also – auf diskreter Basis – die einzelnen Lichtstrahlen auf, und erfasst mit dem Bildsensor für jeden Strahl den Schnittpunkt und die Richtung, aus der er auftrifft. Die 4-D-Informationen können dann nach der Aufnahme verarbeitet werden.

Welche elementaren Techniken stecken dahinter und seit wann gibt es diese eigentlich?

Wie gesagt, darf man die Lichtfeldtechnologie nicht nur auf den Anwendungsbereich der Fotografie beschränken. Sie ist viel fundamentaler. Stellen Sie sich all die Anwendungen vor, die heute digitale Bilder aufnehmen, anzeigen, ver- und bearbeiten, errechnen, und so weiter. All das wird von der Lichtfeldtechnologie adressiert. In der Physik ist das Prinzip der plenoptischen Funktion schon sehr lange bekannt. In der Informatik wurden die ersten Lichtfeldkameras 1996 entwickelt. Mittlerweile gibt es bereits einige kommerzielle Lichtfeldkameras für unterschiedliche Anwendungsgebiete wie Fotografie oder industrielle Bildverarbeitung, Lichtfelddisplays, Lichtfeldbelichtungssysteme, Sensoren sowie Visualisierungs- und Renderingtechniken, die auf Lichtfeldern basieren.

Mit der neuen Fülle an Informationen, die nun in einem Foto stecken, wird die Frage des Speicherplatzes also wieder ein Thema?

Lassen wir das Foto mal außen vor, und reden von dem Unterschied zwischen 2-D-Bildern und 4-D-Lichtfeldern, um hier nicht den Eindruck zu erwecken, dass es nur um Fotografie geht. Heute sind digitale Bilder – wie Fotos, Bilder auf dem Fernseher und so weiter – in Megapixel aufgelöst, ihre Größe liegt im Megabyte-Bereich. Da Lichtfelder keine Pixel sondern Strahleninformationen (Rays) beinhalten, kann man die Auflösung auch nicht mehr in Megapixeln angeben. Lichtfelder haben eine Gigaray-Auflösung und eine Größe im Gigabyte Bereich. Das heißt, der Schritt von digitalen Bildern hin zu digitalen Lichtfeldern ist einer von einer Größenordnung von einer Millionen zu einer Milliarde – in Auflösung und Größe.

Die Frage des Speicherplatzes und der Rechenleistung werden dabei bedingt zu einem Thema, da sie sich sehr viel schneller vergrößern als es bisher für die Auflösung von Bildern der Fall war. Wir entwickeln aber unter anderem auch intelligente Caching-Verfahren, die es ermöglichen, mit solchen riesigen Datenmengen umzugehen.

Letztendlich muss man sich aber eines fragen: Die Auflösung von Fotosensoren wächst auch ständig an. Mittlerweile haben Digitalkameras Sensoren mit 50 Megapixel. Was fängt man mit einer solchen Auflösung überhaupt an? Man benötigt diese Auflösung für „normale“ Anwendungen nicht. Aber, man könnte die hohe Auflösung von Fotosensoren durchaus mit gemultiplexten Informationen darauf sinnvoll nutzen. Das wird ja bei der Verwendung eines Farbfilters vor dem Sensor genauso gemacht. Eine Lichtfeldkamera würde hier aber nicht Farben multiplexen, sondern Richtungen. Demnach wäre ein einfaches Lichtfeld nicht größer als ein zum Beispiel 50 Megapixel aufgelöstes 2-D-Bild. Dahin zielen momentane Anwendungen in der Lichtfeldfotografie. In Zukunft werden Lichtfelder aber um einiges größer sein, unsere Speicherchips und Prozessoren aber hoffentlich dann auch.

Wo sehen Sie noch Verbesserungsbedarf bei Lichtfeldkameras?

Für die momentan kommerziell erhältlichen Kameras in ihrem Preis-Auflösungsverhältnis. Es gibt Kameras, die günstig sind (zwischen 200 und 300 US-Dollar), aber nur eine Ortsauflösung unter 1 MP unterstützen. Andere Kameras unterstützen zumindest schon einmal eine 10MP-Ortsauflösung, kosten dann aber gleich mehr als 35.000 Euro. Man muss bedenken, dass man in beiden Fällen für jeden Ort auch eine Auflösung in der Richtung hat (4-D). 10MP-Ortsauflösung bedeutet hier, dass in Wirklichkeit ein 30-MP-Bildsensor verwendet wurde – der Rest der Pixel wird in Richtungsinformationen abgelegt.

Aber wie gesagt: Lichtfelder sind mehr also nur Kameras und Fotografie. Es gibt aber ein viel größeres Problem als das der Hardware: die Verarbeitung von Lichtfeldern. Es ist nicht möglich, die bekannten Bildverarbeitungstechniken auf Lichtfelder anzuwenden. Hier muss man also in der Tat das Rad wirklich neu erfinden – und genau das tun wir hier in Linz. Sämtliche algorithmischen und mathematischen Grundlagen zur Bildverarbeitung müssen für Lichtfelder neu erdacht werden. Denn man möchte mit Lichtfeldern ja mindestens einmal das tun können, was man heute mit Bildern tut – und hoffentlich noch eine Menge mehr. Die Probleme liegen also mehr in der Soft- als in der Hardware.

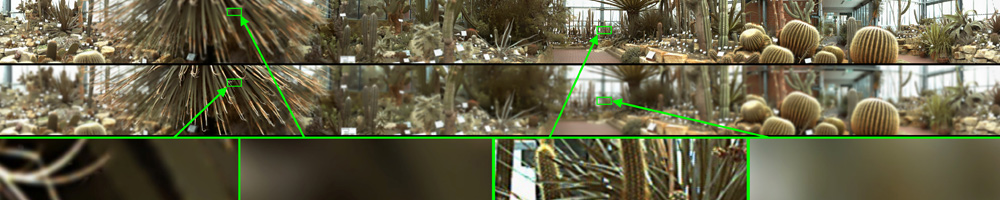

Das weltweit erste Panorama-Lichtfeld mit einer Auflösung von 2.54 Gigarays (2.54 Milliarden Lichtstrahleninformationen) und einer Ortsauflösung von 22 Megapixeln (17.885×1.275 Pixeln) ermöglicht unter anderem das nachträgliche Ändern des Fokus durch Mausklick. Bildcredit: Institut für Computergrafik der Johannes Kepler Universität Linz

Das weltweit erste Panorama-Lichtfeld mit einer Auflösung von 2.54 Gigarays (2.54 Milliarden Lichtstrahleninformationen) und einer Ortsauflösung von 22 Megapixeln (17.885×1.275 Pixeln) ermöglicht unter anderem das nachträgliche Ändern des Fokus durch Mausklick. Bildcredit: Institut für Computergrafik der Johannes Kepler Universität Linz

Hinweis: Am DO 31.1.2013, 20:00, ist Oliver Bimber zu Gast bei „Deep Space LIVE: Lichtfelder – Die Zukunft digitaler Bilder“ im Ars Electronica Center.